Open Compute Project (dosłownie "otwarty projekt obliczeniowy) to przedsięwzięcie inżynierów Facebooka mające na celu opracowanie otwartych i ogólnie dostępnych dla wszystkich standardów budowy centrum danych i jego wyposażenia, które przy najniższych kosztach inwestycji zapewnią najwyższą efektywność energetyczną i moc obliczeniową.

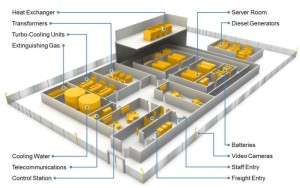

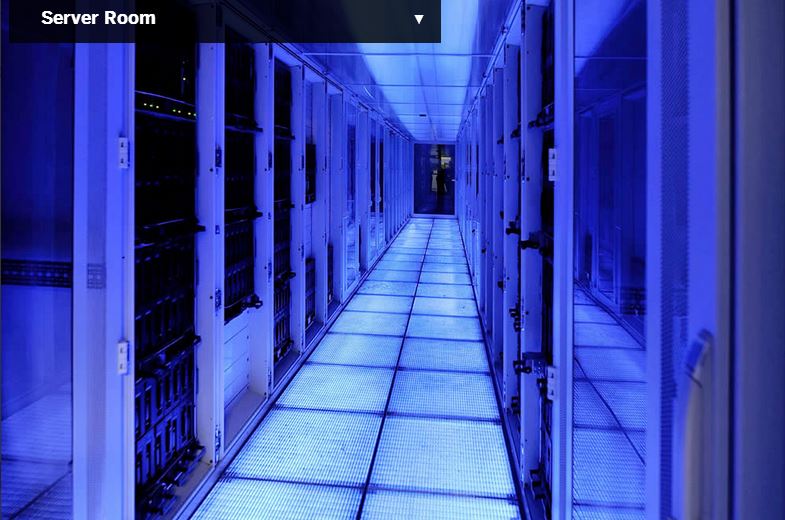

Grupa inżynierów Facebooka spędziła ostatnie kilka lata nad sprostaniem zadania - w jak rozbudować swoją infrastrukturę obliczeniową w najbardziej efektywny i ekonomiczny sposób. Pracując najpierw na środowisku testowym stworzyła założenia, które udało się wdrożyć w wybudowanym od podstaw, zgodnie z pierwszymi wytycznymi projektu data center w Prineville w stanie Oregon (USA). Oprócz odpowiednio zaprojektowanego budynku i układu pomieszczeń (co miało na celu stworzenie maksymalnie efektywnego sposobu chłodzenia) obiekt został wyposażony w opracowane przez zespół serwery wykonane z komponentów komputerów PC, zasilacze UPS, szafy rackowe i system bateryjnego podtrzymania zasilania. Grupa zaczęła wszystkie prace nad projektem od zera, dlatego mógła sobie pozwolić na całkowicie indywidualne podejście do każdego aspektu i zaplanowanie wszystkiego od początku, pomijając wszelkie dostępne, opracowane przez wielkie korporacje informatyczne i infrastrukturalne rozwiązania.

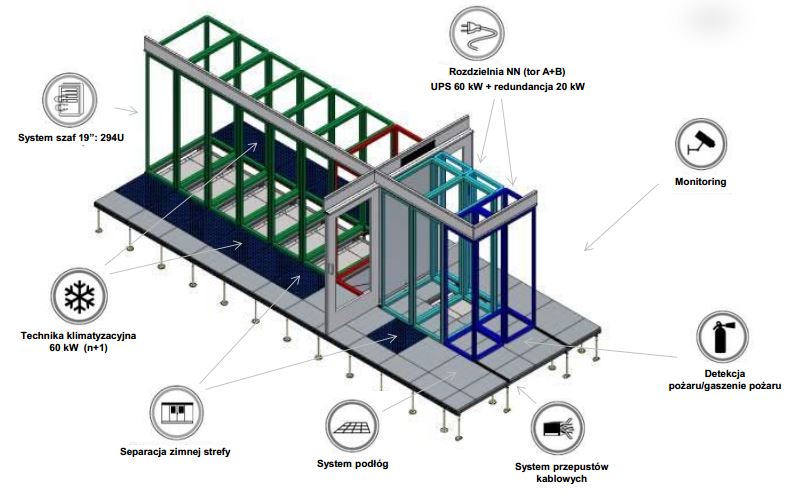

W oparciu o wytyczne OCP powstały już dwa centra danych, jedno - jako pierwsze - wspomniany wyżej obiekt w Prineville w USA oraz drugi w miejscowości Lulea w Szwecji, który to przedstawiłem tutaj. Krótko tylko przypomnę, że obiekt ten wykorzystuje w 100% zewnętrzne powietrze do chłodzenia całej serwerowni. We wspomnianym wpisie skupiłem się jedynie na kwestii budowy data center. OCP jednak obecnie posiada znacznie większy zakres i przedstawia wytyczne:

- budowy serwerów (Server Technology) w tym:

- budowy urządzeń sieciowych (Networking),

- budowy serwerów (Server Design),

- zarządzanie urządzeniami (Hardware Management),

- budowy zasilaczy serwerów (Power Supply),

- budowy obudów serwerów (Chassis),

- budowy urządzeń przechowywania danych (Storage),

- budowy centrum danych (Data Center Technology)

- konstrukcji szaf rackowych (Open Rack),

- konstrukcji szaf akumulatorów (Battery Cabinet),

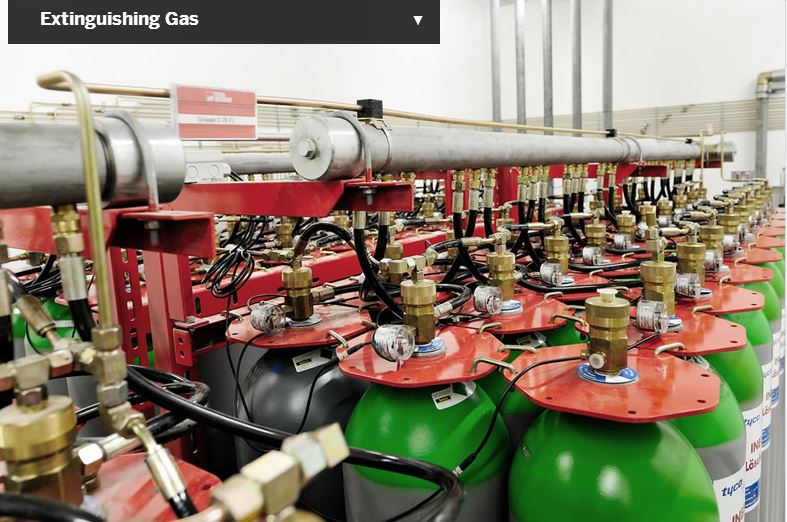

- budowy systemu zasilania (Data Center Electrical),

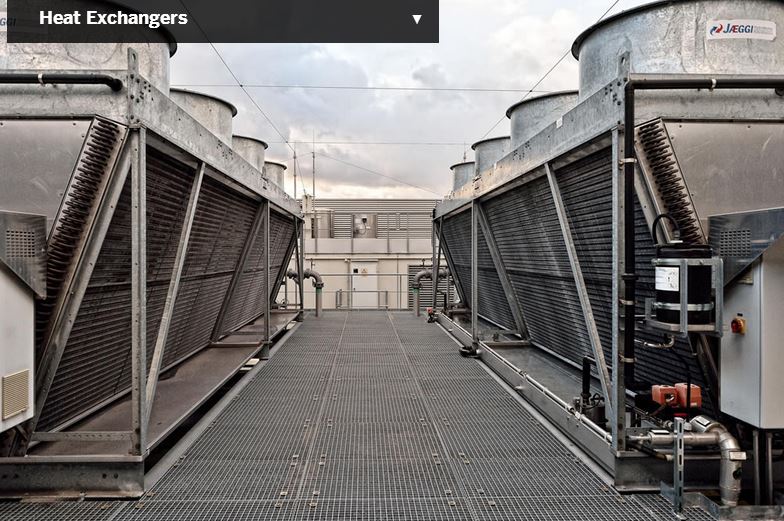

- budowy systemu chłodzenia (Data Center Mechanical).

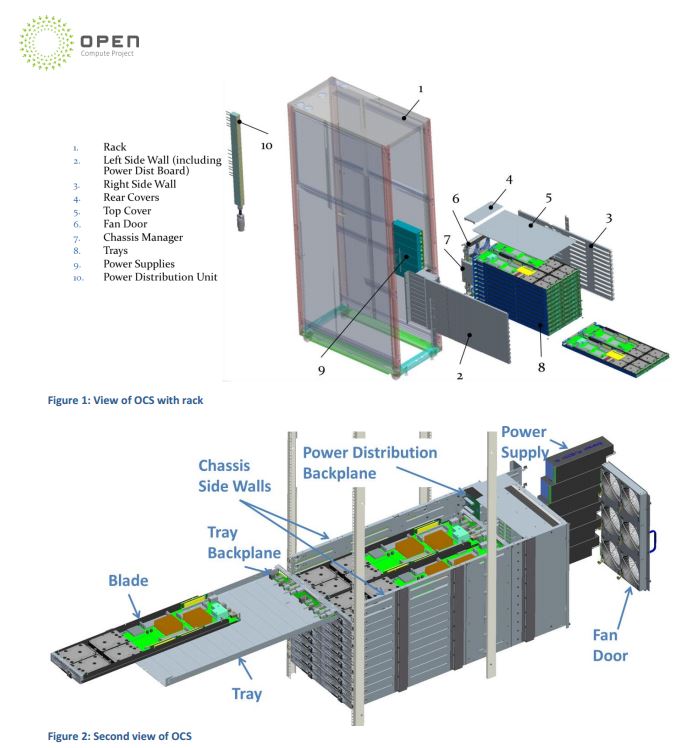

Poniżej przedstawiam fragment specyfikacji dotyczącej budowy serwera nazwanego Open CloudServer (zdjęcie powyżej).

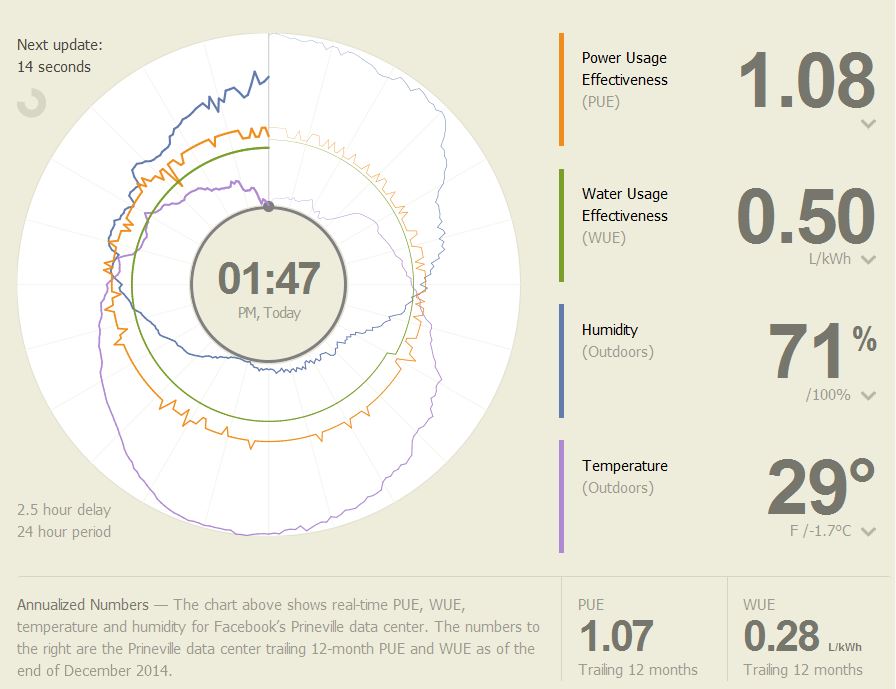

Efekt stosowania opisanych w projekcie rozwiązań (na przykładnie centrum danych w Prineville) to redukcja kosztów inwestycji o 24%, kosztów utrzymania o 34% i osiągnięcie rekordowo niskiego wskaźnika PUE na poziomie 1,07 w skali roku.

Zapraszam do analizy tego wyniku w udostępnionej przez Facebook aplikacji wizualizującej zależność PUE od temperatury zewnętrznej oraz wilgotności. Poniżej zrzut ekranu i wyniki przedstawiane przez aplikację w momencie pisania tej treści.

Open Compute Project przez kilka lat swojego istnienia mocno się rozwiną i obecnie jest to już zestaw wielu dokumentów i specyfikacji, których samo przeczytanie wymaga poświęcenia dużej ilości czasu. Wszelkie informacje i specyfikacje można znaleźć na stronie projektu www.OpenCompute.org.

Moim celem tutaj było jedynie zasygnalizowanie, że istnieje takie przedsięwzięcie, dotyczy wielu aspektów i jest ogólnie dostępne. Czy ktoś z tego zrobi pożytek to już inna sprawa. Chętnie podejmę się takiego zadania jeśli znajdzie się odpowiednio szalony (w pozytywnym tego słowa znaczeniu) inwestor :) .