Kontynuując cykl dotyczący modularnych centrów danych i modularnych serwerowni przedstawiam propozycję firmy Rittal o nazwie RiMatrix S. Tak się szczęśliwie złożyło, że firma ta zorganizowała w ostatnim czasie roadshow po Polsce z przykładową wersją kontenera i miałem okazję zobaczyć produkt od środka. Wydarzenia miało miejsce w czerwcu 2014 roku. Poniżej przedstawiam krótkie streszczenie omawianego rozwiązania.

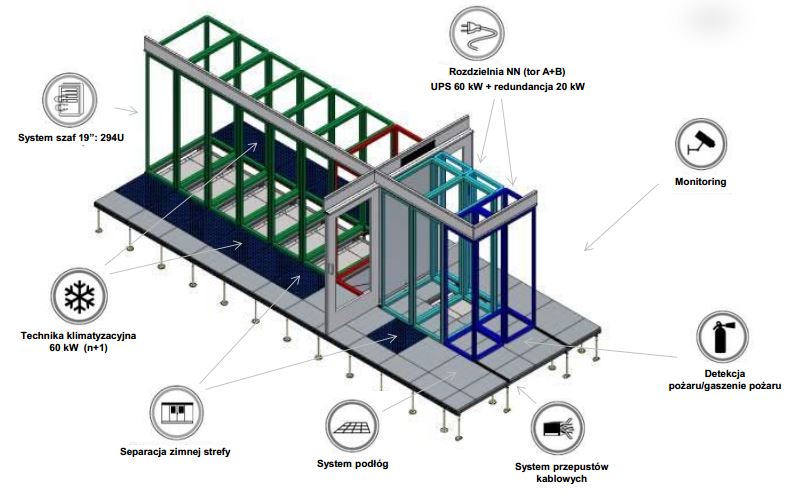

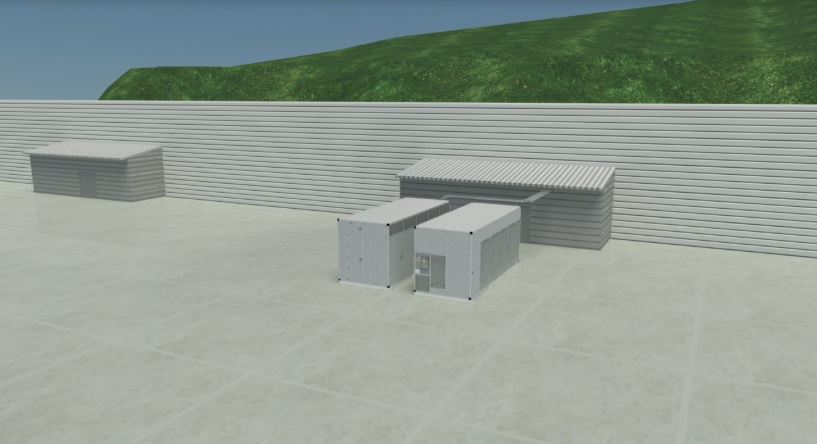

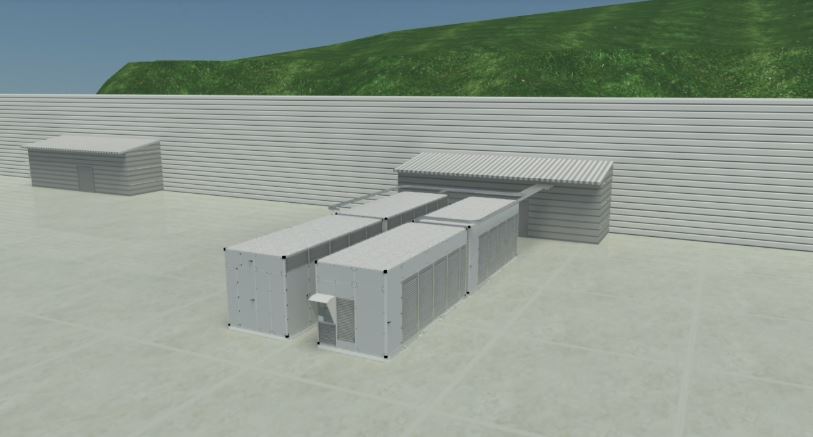

RiMatrix S to zestaw szaf serwerowych, sieciowych, systemu zasilania, chłodzenia itp. zdefiniowany przez producenta i określony katalogowymi parametrami tworzący jako całość modularne data center, które na życzenie klienta może zostać zainstalowana w jednej z trzech opcji.

- Wersja kontenerowa - posadowienie na zewnątrz budynku.

- Wersja wewnętrzna podstawowa - instalacja systemu w jednym z pomieszczeń budynku.

- Wersja wewnętrzna w bezpiecznym pomieszczeniu IT Security Room wewnątrz budynku.

System oraz opcje instalacji przedstawiam na poniżej zamieszczonych obrazkach zaczerpniętych ze strony producenta oraz z materiałów udostępnionych mi przez firmę Rittal.

Dwa pierwsze obrazki przedstawiają podstawowy moduł systemu, który może być skalowany poprzez dostawianie kolejnych modułów w miarę potrzeb.

I poniżej zdjęcia przedstawiające wersję kontenerową, które zostały zrobione podczas wspomnianego roadshow we Wrocławiu.

System zapewnia obsługę maksymalnej moc 1o kW na jedną szafę serwerową. Jako główne zalety producent wymienia:

- Niższe koszty inwestycji.

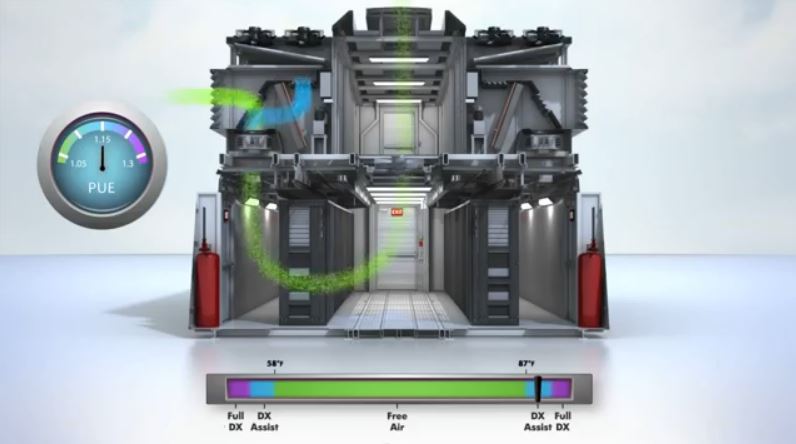

- Gwarantowany wskaźnik PUE = 1.1.

- Znacznie uproszczona i skrócona faza projektowania.

- Niższe koszty serwisowania.

- Krótki termin dostawy z produkcji seryjnej.

- Pełna dokumentacja, testy systemu, certyfikowane moduły TÜV Rheinland wg PN-EN 50600-1; VDE 0801-600-1:2012-01.

Należy pamiętać, że konieczne jest - niezależnie od wersji - zapewnienia miejsca dla jednostek zewnętrznych systemu klimatyzacji oraz ewentualnego systemu zasilania rezerwowanego.

Co do kosztów i czasu realizacji, jak zawsze zależy do czego porównać...

Transport modułu. [2]

Transport modułu. [2]

Obrazek pokazujący przepływ powietrza przez moduł. [4]

Obrazek pokazujący przepływ powietrza przez moduł. [4]

Widok przyłączy źródła chłodu. [1]

Widok przyłączy źródła chłodu. [1]