Artykuł ten przedstawia opisowy przykład centrum danych z serwerownią o mocy elektrycznej sprzętu IT równej 180 kW zaplanowanym w istniejącym budynku. Obiekt ma znaczenie krytyczne dla funkcjonowania biznesu jego właściciela, dlatego projekt wymagał zastosowania odpowiednio niezawodnych rozwiązań, które pokrótce tutaj opiszę.

Analizowane centrum danych powstało na potrzeby instytucji, dla której system informatyczny jest warunkiem istnienia i każda chwila przestoju niesie za sobą ogromne straty finansowe, dlatego całość musiała zostać tak zaprojektowana, aby można było wykonywać wszelkie prace związane z rozbudową systemu bez konieczności wyłączania elementów systemu. Ponadto ciągłość działania musiała być zapewniona nawet w przypadku długotrwałej awarii elektrowni energetycznej będącej źródłem prądu.

Data center, w tym przypadku, składa się z kilku pomieszczeń funkcjonalnych: UPS-ownia, pomieszczenie dystrybucji energii, pomieszczenie agregatu prądotwórczego, pomieszczenie techniczne oraz najważniejsze – serce układu – serwerownia. Całość została wykonana w istniejącym budynku, którego część została odpowiednio zaadoptowana. Wymagało to wykonania szeregu prac konstrukcyjno-budowlanych, instalacji przyłączy energetycznych i przystosowania sąsiedniego budynku garażowego na potrzeby wytwarzania zasilania rezerwowanego (agregat prądotwórczy).

Główne parametry omawianego centrum danych:

- Powierzchnia całego centrum danych: około 200 m2

- Powierzchnia serwerowni: 110m2

- Moc elektryczna przeznaczona na sprzęt IT: 180 kW

- Podział gęstości mocy: 2 strefy

- Zabudowy chłodnych korytarzy

- Klimatyzacja rzędowa

Aranżacja pomieszczenia serwerowni i UPS-owni

Ze względu na posiadane przez Inwestora specyficzne macierze dyskowe pomieszczenie serwerowni wymagało podziału na dwie strefy (zabudowy/układu szaf i klimatyzacji), co było ułatwione przez jego kształt. Powierzchnia całkowita wynosiła 110m2. Główna strefa zbudowana z 24 szaf serwerowych o łącznej mocy 130 kW oraz 9 klimatyzatorów rzędowych w układzie N+2 dostarczających stale około 150 kW chłodu. Szafy i klimatyzatory podzielone zostały na dwa rzędy z zabudowaną strefą chłodu pomiędzy nimi (zabudowa stała, wejście do strefy przez drzwi). Tak samo została zorganizowana druga strefa zbudowana z 10 dużych macierzy dyskowych oraz 4 klimatyzatorów rzędowych. Moc elektryczna dla sprzętu IT tej części to 50kW i moc chłodu to 58kW przy założeniu trzech stale działających klimatyzatorów. Ze względu na niestandardowe wymiary szaf macierzowych wykonano zabudowę modularną (elastyczne pasy, bez dedykowanych drzwi). Dokoła szaf wykonano trasy kablowe dedykowane dla okablowania strukturalnego i połączeń sieciowych pomiędzy urządzeniami instalowanymi w szafach. Poniższy rysunek przedstawia rzut pomieszczenia serwerowni w wersji projektowej.

Pomieszczenie UPS-owni o powierzchni 50m2 ma za zadanie utrzymać odpowiednie warunki dla dwóch równoległych układów zasilaczy UPS w konfiguracji N+1 o stale dostępnej mocy 180kW każdy. Zaplanowano w nim klimatyzację precyzyjną typu InRoom chłodzącą całe pomieszczenie.

Instalacje elektryczne

Instalacje elektryczne centrum danych o znaczeniu krytycznym oraz tej wielkości mocy to już ciekawe zagadnienie inżynieryjne. Ogromna ilość odpowiednio dobranych przewodów, zarówno o małych jak i dużych przekrojach, skonfigurowanych i połączonych w odpowiednich konfiguracjach tworzy interesujący system. Do budynku doprowadzono zasilanie redundantne z dwóch niezależnych źródeł. Docelowo zaplanowano zasilanie wszystkich szaf dwutorowo dla zwiększenia niezawodności oraz umożliwienia ewentualnych prac serwisowych jednego z torów zasilania.

Dla kontroli poziomu obciążenia elektrycznego szaf serwerowych oraz ilości mocy dostępnej dla danego obwodu zastosowano analizatory sieci zasilania każdej szafy rack, całego układu klimatyzacji (jednostki wewnętrzne i jednostki zewnętrzne), obwodów zasilania itp. Rozwiązanie takie zapewniło również możliwość pomiaru realnej wartości mocy używanej w danej chwili lub w pewnym okresie przez np. układ klimatyzacji.

Klimatyzacja pomieszczenia serwerowni i UPS-owni

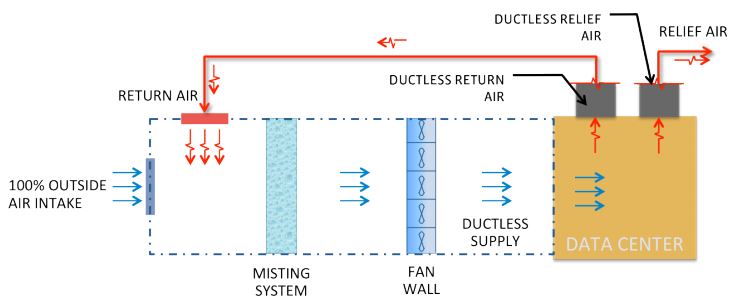

Dla zapewnienia odpowiednich warunków pracy sprzętu IT zastosowano w serwerowni systemy separacji chłodu i ciepła oraz klimatyzację rzędową jako bardziej wydajne i skuteczne oraz mniej stratne, eliminujące wiele dotychczas występujących problemów w serwerowniach rozwiązanie.

Całość chłodzenia serwerowni oparta została o technologię wody lodowej wraz z opcją freecoolingu, która w naszej strefie klimatycznej daje duże oszczędności kosztów jej zasilania przez sporą część roku. Oszczędność ta, dla okresu o temperaturze zewnętrznej poniżej 1oC, będzie wynosiła nawet 100% dla zastosowanych agregatów.

W pomieszczeniu UPS-owni zastosowano trzy szafy precyzyjne chłodzące całe pomieszczenie z nawiewem chłodu pod podłogę techniczną.

Przy projektowaniu systemu chłodzenia serwerowni stale opierano się na symulacjach komputerowych obiegu powietrza przy użyciu programu typu CFD. Więcej o tym napisałem w odrębnym artykule.

System zasilania gwarantowanego oraz rezerwowanego

W pomieszczeniu UPS-owni zainstalowano dwa układy zasilaczy UPS. Każdy układ zbudowany z 4 x UPS 80 kVA pracujących w układzie N+1. Każdy z układów posiada moc wystarczającą do zasilenia wszystkich szaf serwerowych o pełnej mocy czyli około 180 kW. Każda szafa rack została wyposażona w podwójny układ listew PDU z czego jeden zasilany jest z jednego natomiast drugi z drugiego toru UPS-ów. Założono tutaj, że każdy sprzęt serwerowy instalowany w szafach wyposażony będzie w dwa zasilacze. Ze względu na krótki czas rozruchu agregatu prądotwórczego system klimatyzacji nie wymagał podłączenia do zasilania gwarantowanego, co w przeciwnym wypadku miałoby znaczny wpływ na koszt inwestycji. Zasilaniem rezerwowym jest agregat prądotwórczy, który przejmie zasilanie całego centrum danych w krótkim czasie po zaniku dwóch źródeł zasilania obiektu.

Systemy bezpieczeństwa.

- KD – Kontrola dostępu

System kontroli dostępu ma za zadanie zabezpieczenie pomieszczeń centrum danych przed dostępem osób nieuprawnionych. Dostęp do określonych pomieszczeń kontrolowany jest przez system czytników linii papilarnych, kart zbliżeniowych i kodu PIN. Autoryzacja przebiega dwustronnie (wejście/wyjście). Wszystkie wejścia i wyjścia personelu do pomieszczeń są zapisywane w pamięci systemu.

- SSWiN – System sygnalizacji włamania i napadu

System SWiN ma za zadanie sygnalizowania każdego przypadku naruszenia zabezpieczeń pomieszczeń centrum danych. Zastosowanymi elementami odpowiedzialnymi za wykrywanie intruzów są czujki dualne zapewniające analizę warunków otoczenia w pełnym zakresie częstotliwości prędkości ruchu pozwalając na wykrywanie intruzów przy równoczesnej eliminacji czynników środowiskowych i wynikających z nich fałszywych alarmów. Czujki ponadto posiadają funkcję „antymaskingu”, która gwarantuje jej ochronę przed niepożądanym zbliżaniem się do niej i próbami jej maskowania w odległości 0,8 m i bliżej.

- CCTV – System telewizji przemysłowej

System telewizji przemysłowej oparty został o zestaw odpowiednio rozmieszczonych cyfrowych, megapikselowych kamer dookólnych. Całość obrazu (tylko w przypadku wykrycia ruchu) jest rejestrowana na odpowiednim rejestratorze cyfrowym o dużej pojemności, dzięki czemu archiwizowany obraz zapewnia możliwość odtworzenia zdarzeń sprzed wielu miesięcy. Stały podgląd jak i odtwarzanie zarejestrowanego obrazu dostępne są z dowolnej lokalizacji z dostępem do sieci Internet.

System przeciwpożarowy

Serwerownia została zabezpieczona systemem wykrywania pożaru i gaszenia gazem, natomiast pomieszczenie UPS i techniczne tylko systemem wykrywania pożaru. Całość jest kontrolowana przez jedną zaawansowaną centralę ppoż.

Dodatkowo w pomieszczeniu serwerowni zastosowano system bardzo wczesnej detekcji dymu, który dużo wcześniej potrafi wykryć cząstki dymu niż konwencjonalny system wykrywania pożaru reagujący dopiero w momencie sporego nagromadzenia się dymu. Ma to szczególnie znaczenie w serwerowni, gdzie powietrze jest stale mieszane i nagromadzenie się większej ilości dymu dotyczy całej kubatury pomieszczenia. W standardowym systemie czujki wykrywające rozmieszczone są w kilku miejscach. Tutaj natomiast zainstalowana jest sieć rur ssących, przez które stale przetłaczane jest powietrze dzięki pompce ssącej znajdującej się w centrali.

Szafy sererowe

Dla kompletności i możliwości wykonania zabudowy zastosowano jednolite szafy RACK producenta, który również oferuje systemy zabudowy korytarzy pomiędzy szafami. Dostarczone szafy posiadają wymiary 42U x 800mm x 1100mm, nośność 1000kg. Ze względu na zamykane wejście do zabudowy oraz bezpieczne wejście do serwerowni tylko dla autoryzowanych pracowników, instalację drzwi do każdej z szaf uznano za zbędną. Zasilanie jest realizowane przez cztery listwy (po dwie na stronę) po 20 slotów, o długości 90cm, zainstalowane pionowo z tyłu szaf.Wszystkie wolne miejsca w szafach, gdzie jeszcze nie zainstalowano sprzętu serwerowego, zostały zaślepione panelami maskującymi w celu wyeliminowania efektu mieszania się chłodu z ciepłem oraz uszczelnienia zabudowy. Zastosowane szafy zostały wyposażone we wzmocnione profile, charakteryzujące się dużą obciążalności. Profile te wyposażone są w dodatkowe 3 pola 19” 1U co dało 6 dodatkowych pól 19” 1U pozwalających na montaż dodatkowych urządzeń lub paneli pionowo po bokach szafy.

Trasy kablowe

Trasy podwieszane nad szafami serwerowymi tworzą bardzo funkcjonalne i praktyczne możliwości prowadzenia okablowania pomiędzy sprzętem serwerowo-sieciowym w serwerowni. W bardzo łatwy sposób umożliwiają rozbudowę okablowania w każdym momencie bez otwierania płyt podłogowych i przeciągania po kawałku kabli. Dodatkowo trasy takie tworzą ciekawie wygląd pomieszczenia.

Monitoring warunków środowiskowych i stanu pracy urządzeń (SMS)

Całe centrum danych składała się z dużej ilości urządzeń, systemów i instalacji. Jest bardzo ważne, aby mieć nad tym wszystkim kontrolę, co najmniej na poziomie informacji o stanie. W środowisku tak rozbudowanym awaria bez odpowiednio wczesnego powiadomienia może zakończyć się niebezpiecznie lub w ogóle zostać wykryta po dłuższym czasie. Dlatego też zainstalowano monitoring warunków środowiskowych i stanu pracy urządzeń (SMS –Security Management System). Do systemu podpięte zostały wszystkie urządzenia, które mogą zgłaszać swój stan. Dodatkowo np. na obwodach zasilania zostały zainstalowane specjalne przekaźniki informujące o stanie zabezpieczenia. Analizatory sieci wysyłają dane również do tego systemu. Wszystkie te informacje (około 310 sygnałów dla analizowanego centrum danych) dostępne są za pośrednictwem zainstalowanego Web serwera przez przeglądarkę internetową, a wybrane, uznane za krytyczne, aby natychmiast informowały o zagrożeniu są wysyłane za pomocą wiadomości SMS.

Podsumowanie

Opisywane centrum danych, a w szczególności serwerownia zostały dokładnie przeanalizowane w fazie projektowej. Dzięki użycie modelowania komputerowego wyeliminowano wszelkie możliwe nieefektywności chłodzenia zanim w ogóle system klimatyzacji został wykonany. Dodatkowo zastosowanie zabudowy chłodnych korytarzy pomiędzy szafami serwerowymi w pomieszczeniu serwerowni oraz wykorzystanie technologii feree coolingu zapewni znaczne zmniejszenie kosztów zasilania systemu. Warto też zauważyć fakt, że dobrze przemyślana organizacja systemów, typu i sposobu prowadzenia tras kablowych, rozmieszczenia szaf itp., to duże ułatwienie w codziennej pracy związanej z instalacją i fizyczną obsługą sprzętu serwerowego itp.